Nginx服務器中accept鎖的機制與實現詳解

文章主要給大家介紹了關于Nginx中accept鎖的機制與實現的相關資料,文中通過示例代碼介紹的非常詳細,對大家的學習或者工作具有一定的參考學習價值,...

前言

nginx采用多進程的模,當一個請求過來的時候,系統會對進程進行加鎖操作,保證只有一個進程來接受請求。

本文基于Nginx 0.8.55源代碼,并基于epoll機制分析

1. accept鎖的實現

1.1 accpet鎖是個什么東西

提到accept鎖,就不得不提起驚群問題。

所謂驚群問題,就是指的像Nginx這種多進程的服務器,在fork后同時監聽同一個端口時,如果有一個外部連接進來,會導致所有休眠的子進程被喚醒,而最終只有一個子進程能夠成功處理accept事件,其他進程都會重新進入休眠中。這就導致出現了很多不必要的schedule和上下文切換,而這些開銷是完全不必要的。

而在Linux內核的較新版本中,accept調用本身所引起的驚群問題已經得到了解決,但是在Nginx中,accept是交給epoll機制來處理的,epoll的accept帶來的驚群問題并沒有得到解決(應該是epoll_wait本身并沒有區別讀事件是否來自于一個Listen套接字的能力,所以所有監聽這個事件的進程會被這個epoll_wait喚醒。),所以Nginx的accept驚群問題仍然需要定制一個自己的解決方案。

accept鎖就是nginx的解決方案,本質上這是一個跨進程的互斥鎖,以這個互斥鎖來保證只有一個進程具備監聽accept事件的能力。

實現上accept鎖是一個跨進程鎖,其在Nginx中是一個全局變量,聲明如下:

ngx_shmtx_t ngx_accept_mutex;

這是一個在event模塊初始化時就分配好的鎖,放在一塊進程間共享的內存中,以保證所有進程都能訪問這一個實例,其加鎖解鎖是借由linux的原子變量來做CAS,如果加鎖失敗則立即返回,是一種非阻塞的鎖。加解鎖代碼如下:

staticngx_inline ngx_uint_tngx_shmtx_trylock(ngx_shmtx_t *mtx){return(*mtx->lock == 0 && ngx_atomic_cmp_set(mtx->lock, 0, ngx_pid));}#define ngx_shmtx_lock(mtx) ngx_spinlock((mtx)->lock, ngx_pid, 1024)#define ngx_shmtx_unlock(mtx) (void) ngx_atomic_cmp_set((mtx)->lock, ngx_pid, 0)

可以看出,調用ngx_shmtx_trylock失敗后會立刻返回而不會阻塞。

1.2 accept鎖如何保證只有一個進程能夠處理新連接

要解決epoll帶來的accept鎖的問題也很簡單,只需要保證同一時間只有一個進程注冊了accept的epoll事件即可。

Nginx采用的處理模式也沒什么特別的,大概就是如下的邏輯:

嘗試獲取accept鎖

if 獲取成功:

在epoll中注冊accept事件

else:

在epoll中注銷accept事件

處理所有事件

釋放accept鎖

當然這里忽略了延后事件的處理,這部分我們放到后面討論。

對于accept鎖的處理和epoll中注冊注銷accept事件的的處理都是在ngx_trylock_accept_mutex中進行的。而這一系列過程則是在nginx主體循環中反復調用的void ngx_process_events_and_timers(ngx_cycle_t *cycle)中進行。

也就是說,每輪事件的處理都會首先競爭accept鎖,競爭成功則在epoll中注冊accept事件,失敗則注銷accept事件,然后處理完事件之后,釋放accept鎖。由此只有一個進程監聽一個listen套接字,從而避免了驚群問題。

1.3 事件處理機制為不長時間占用accept鎖作了哪些努力

accept鎖處理驚群問題的方案看起來似乎很美,但如果完全使用上述邏輯,就會有一個問題:如果服務器非常忙,有非常多事件要處理,那么“處理所有事件這一步”就會消耗非常長的時間,也就是說,某一個進程長時間占用accept鎖,而又無暇處理新連接;其他進程又沒有占用accept鎖,同樣無法處理新連接——至此,新連接就處于無人處理的狀態,這對服務的實時性無疑是很要命的。

為了解決這個問題,Nginx采用了將事件處理延后的方式。即在ngx_process_events的處理中,僅僅將事件放入兩個隊列中:

ngx_thread_volatile ngx_event_t *ngx_posted_accept_events;ngx_thread_volatile ngx_event_t *ngx_posted_events;

返回后先處理ngx_posted_accept_events后立刻釋放accept鎖,然后再慢慢處理其他事件。

即ngx_process_events僅對epoll_wait進行處理,事件的消費則放到accept鎖釋放之后,來最大限度地縮短占有accept的時間,來讓其他進程也有足夠的時機處理accept事件。

那么具體是怎么實現的呢?其實就是在static ngx_int_t ngx_epoll_process_events(ngx_cycle_t *cycle, ngx_msec_t timer, ngx_uint_t flags)的flags參數中傳入一個NGX_POST_EVENTS的標志位,處理事件時檢查這個標志位即可。

這里只是避免了事件的消費對于accept鎖的長期占用,那么萬一epoll_wait本身占用的時間很長呢?這種事情也不是不可能發生。這方面的處理也很簡單,epoll_wait本身是有超時時間的,限制住它的值就可以了,這個參數保存在ngx_accept_mutex_delay這個全局變量中。

下面放上ngx_process_events_and_timers 的實現代碼,可以大概一觀相關的處理:

voidngx_process_events_and_timers(ngx_cycle_t *cycle){ngx_uint_t flags;ngx_msec_t timer, delta;/* 省略一些處理時間事件的代碼 */// 這里是處理負載均衡鎖和accept鎖的時機if(ngx_use_accept_mutex) {// 如果負載均衡token的值大于0, 則說明負載已滿,此時不再處理accept, 同時把這個值減一if(ngx_accept_disabled > 0) {ngx_accept_disabled--;}else{// 嘗試拿到accept鎖if(ngx_trylock_accept_mutex(cycle) == NGX_ERROR) {return;}// 拿到鎖之后把flag加上post標志,讓所有事件的處理都延后// 以免太長時間占用accept鎖if(ngx_accept_mutex_held) {flags |= NGX_POST_EVENTS;}else{if(timer == NGX_TIMER_INFINITE|| timer > ngx_accept_mutex_delay){timer = ngx_accept_mutex_delay;// 最多等ngx_accept_mutex_delay個毫秒,防止占用太久accept鎖}}}}delta = ngx_current_msec;// 調用事件處理模塊的process_events,處理一個epoll_wait的方法(void) ngx_process_events(cycle, timer, flags);delta = ngx_current_msec - delta;//計算處理events事件所消耗的時間ngx_log_debug1(NGX_LOG_DEBUG_EVENT, cycle->log, 0,"timer delta: %M", delta);// 如果有延后處理的accept事件,那么延后處理這個事件if(ngx_posted_accept_events) {ngx_event_process_posted(cycle, &ngx_posted_accept_events);}// 釋放accept鎖if(ngx_accept_mutex_held) {ngx_shmtx_unlock(&ngx_accept_mutex);}// 處理所有的超時事件if(delta) {ngx_event_expire_timers();}ngx_log_debug1(NGX_LOG_DEBUG_EVENT, cycle->log, 0,"posted events %p", ngx_posted_events);if(ngx_posted_events) {if(ngx_threaded) {ngx_wakeup_worker_thread(cycle);}else{// 處理所有的延后事件ngx_event_process_posted(cycle, &ngx_posted_events);}}}

再來看看ngx_epoll_process_events的相關處理:

// 讀事件if((revents & EPOLLIN) && rev->active) {if((flags & NGX_POST_THREAD_EVENTS) && !rev->accept) {rev->posted_ready = 1;}else{rev->ready = 1;}if(flags & NGX_POST_EVENTS) {queue = (ngx_event_t **) (rev->accept ?&ngx_posted_accept_events : &ngx_posted_events);ngx_locked_post_event(rev, queue);}else{rev->handler(rev);}}wev = c->write;// 寫事件if((revents & EPOLLOUT) && wev->active) {if(flags & NGX_POST_THREAD_EVENTS) {wev->posted_ready = 1;}else{wev->ready = 1;}if(flags & NGX_POST_EVENTS) {ngx_locked_post_event(wev, &ngx_posted_events);}else{wev->handler(wev);}}

處理也相對簡單,如果拿到了accept鎖,就會有NGX_POST_EVENTS標志那么就會放到相應的隊列中。沒有的話就會直接處理事件。

總結

以上就是Nginx服務器中accept鎖的機制與實現詳解的全部內容了,希望本文的內容對大家的學習或者工作具有一定的參考學習價值。

Nginx利用Lua+Redis實現動態封禁IP的方法

文章主要介紹了Linux系統下Nginx支持ipv6的方法,小編覺得挺不錯的,現在分享給大家,也給大家做個參考。一起跟隨小編過來看看吧一、查看現有nginx是否支持ipv6需要執行以下命令,...

Linux系統服務器下Nginx支持ipv6配置的方法

文章主要介紹了Linux系統下Nginx支持ipv6的方法,小編覺得挺不錯的,現在分享給大家,也給大家做個參考。一起跟隨小編過來看看吧一、查看現有nginx是否支持ipv6需要執行以下命令,...

Linux服務器下 php7安裝redis的方法

文章主要介紹了Linux下 php7安裝redis的方法,非常不錯,具有一定的參考借鑒價值,需要的朋友可以參考下安裝redis服務1 下載redis cd /usr/local/ 進入安裝目錄 wget http://dow...

Nginx單IP地址配置多個SSL證書的方法示例

文章主要介紹了Nginx單IP地址配置多個SSL證書的方法示例,小編覺得挺不錯的,現在分享給大家,也給大家做個參考。一起跟隨小編過來看看吧默認情況下,Nginx一個IP地址僅支持一個SSL...

利用nginx和騰訊云免費證書制作https的方法

文章主要介紹了利用nginx和騰訊云免費證書制作https的方法,小編覺得挺不錯的,現在分享給大家,也給大家做個參考。一起跟隨小編過來看看吧之前一直在研究,https怎么弄。最近看到...

Vue.js請求JSON Server服務器數據的實現方法

文章主要介紹了Vue.js請求JSON Server服務器數據的實現方法,需要的朋友可以參考下。由于這里是在之前《vue.js中的vue-resource示例詳解》的基礎上進行稍加修改完成的,因而其...

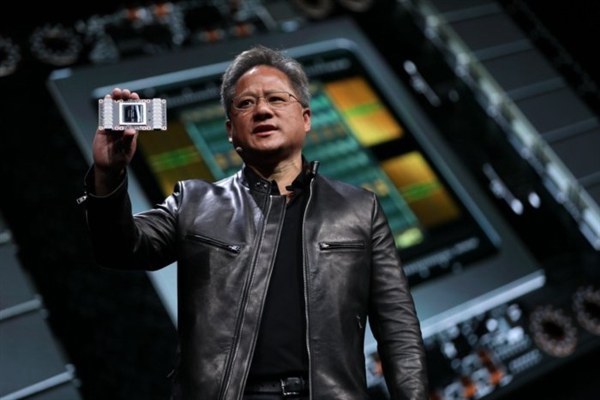

NVIDIA GPU服務器升級:16塊450W Tesla V100

NVIDIA今天發布了升級版的GPU計算服務器“DGX-2H”,和上代DGX-2一樣配備多達16顆Tesla V100 GPU,但熱設計功耗從350W開放到450W,性能更上一層樓。Tesla V100是迄今為...

組裝一臺私人云存儲主機配置推薦 家庭NAS云存儲服務器搭建

如今互聯網上的網盤不斷關停,越來越覺得網盤不靠譜,有些重要資料放到網盤中,可能面臨著網盤關停的風險,加之網盤用的是別人公司的服務器,說刪除你的重要文件就刪除,基本沒得商量,不...

網傳美國關閉根服務器分分鐘掐斷中國網絡?專家:無稽之談

網絡傳言美國能分分鐘掐斷中國網絡,是因為美國掌管著全球13臺根服務器中的10臺。這是真的嗎?8月15日,在2018中國網絡安全年會上,互聯網域名系統北京市工程研究中心主任董事長毛...

《絕地求生》官方比賽服務器翻車:PUBG凌晨致歉

《絕地求生》服務器不穩定是出了名了,游戲重連、炸房、閃退等問題層出不窮。昨日,在PUBG主辦的《絕地求生》頭號直播間主播娛樂賽中,又意外翻車了。據悉,這是PUBG公司主辦的首個...